【新智元导读】小扎目标让Meta AI成全世界最好用的AI助手,但实测来看,还有很长的路要走,至少现在还是远远不如Bing Copilot,除了免费.

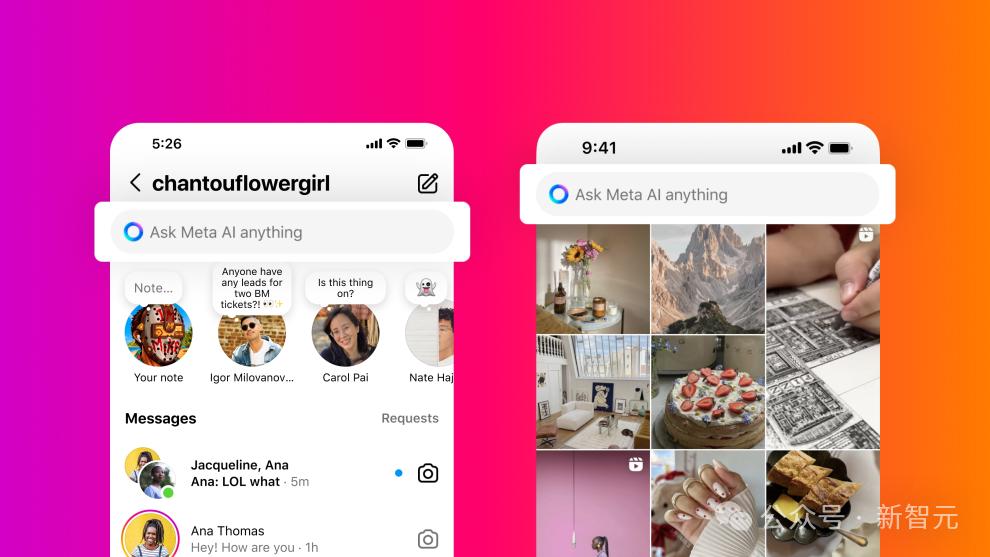

Llama 3开源后,聊天机器人Meta AI也宣布使用新模型作为基座,在Meta旗下的各种软件(Meta.ai、Instagram、Facebook、WhatsApp)中都可以进行免费体验。

可以说,Meta AI承载了全公司的希望,扎克伯格甚至表示,他希望Meta AI成为「世界上使用最多、最好的人工智能助手」。

加装Llama 3后的Meta AI,实战效果如何?

最近,有作者对Meta AI进行了一场用户测试,没有使用已经成型的各种基准数据集,而是作为一个普通用户,输入一些日常生活中的常见问题,并分享使用体验。

总体来说,作为一个通用机器人,Meta AI的效果有时还不如Google搜索,存在引用链接过少、无法准确理解用户意图、偏见、过度拒绝等问题,但胜在免费,还不限制用量。

新闻实事

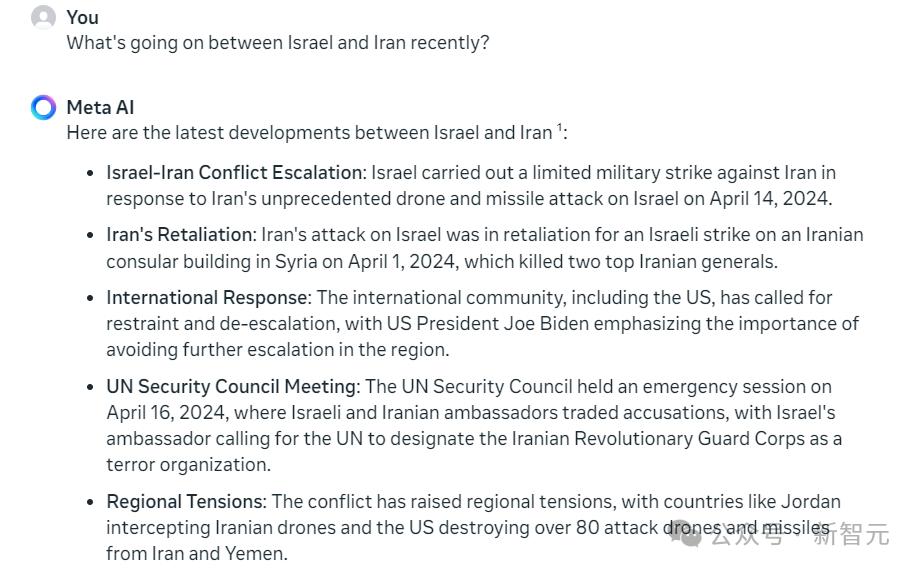

当询问Meta AI关于以色列和伊朗之间的战争时,模型能够以简洁的、项目符号列表的形式进行回复,回复内容中也包括日期,最后还引用了一篇文章,结尾是一个指向Bing搜索的链接,作为对比,Instagram上的模型回复是指向Google搜索的链接。

Meta AI的发言人也表示,与Bing搜索之间是推广合作伙伴关系。

为了检查Meta AI是否在某种程度上依赖于Bing本身的AI模型(微软反过来从OpenAI借用),作者还尝试要求Bing Copilot对同样的提示词进行回答,虽然回复的信息大致相同,但Bing的内联链接和引用更多,二者绝对是不同的模型。

总之,Meta AI的回答是事实性的,而且是最新的,尽管不是特别有说服力(引用过少)。

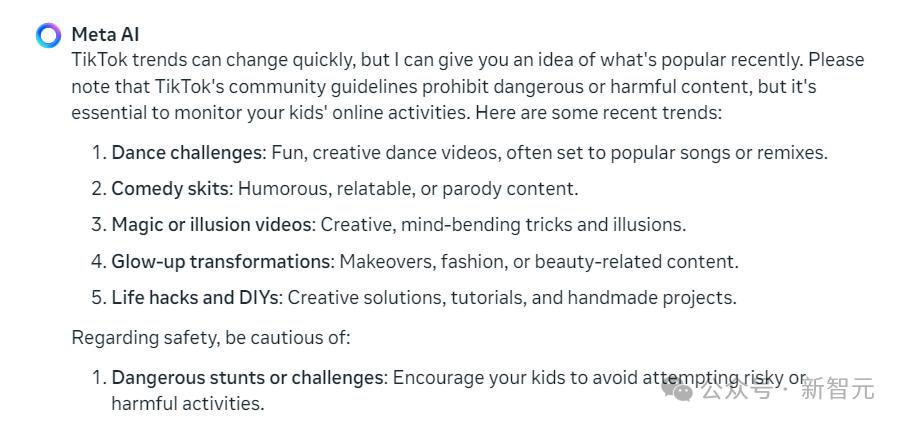

作者还问题了模型关于「TikTok上是否有父母应该注意的最新趋势」,模型能够以非常抽象、高层次的总结回答了创作者在社交网络上的内容,但并不是最近的(如喜剧小品:幽默、可关联或模仿的内容,Comedy skits: Humorous, relatable, or parody content)。

历史问题

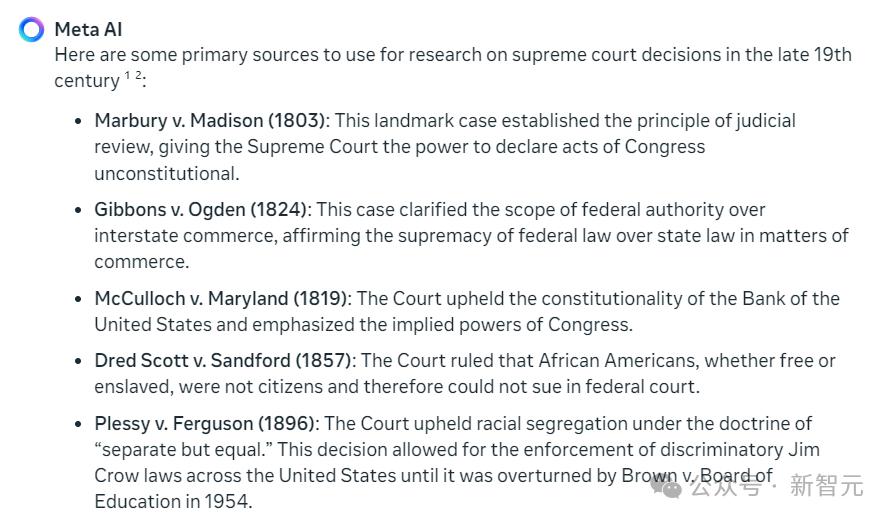

当要求Meta AI搜索一些「19 世纪末最高法院的判决」的资料时,模型给出的回复在很大程度上来自于一个针对搜索引擎优化(SEO-ed)后的帖子,其中列出了许多著名的 19 世纪决策,但并不完全符合要求。

模型最后它还列出了 1896 年人民党(People’s Party)的创始文件,它在当年是左倾政党,与最高法院没有任何关系,但Meta AI引用了该页面,其中描述了一些法官与该党持有相反的观点,一个基本不相关的网页。

作者表示,其他模型可以提供时代趋势的背景和总结,Meta AI 作为一个科研助手来说是不合格的。

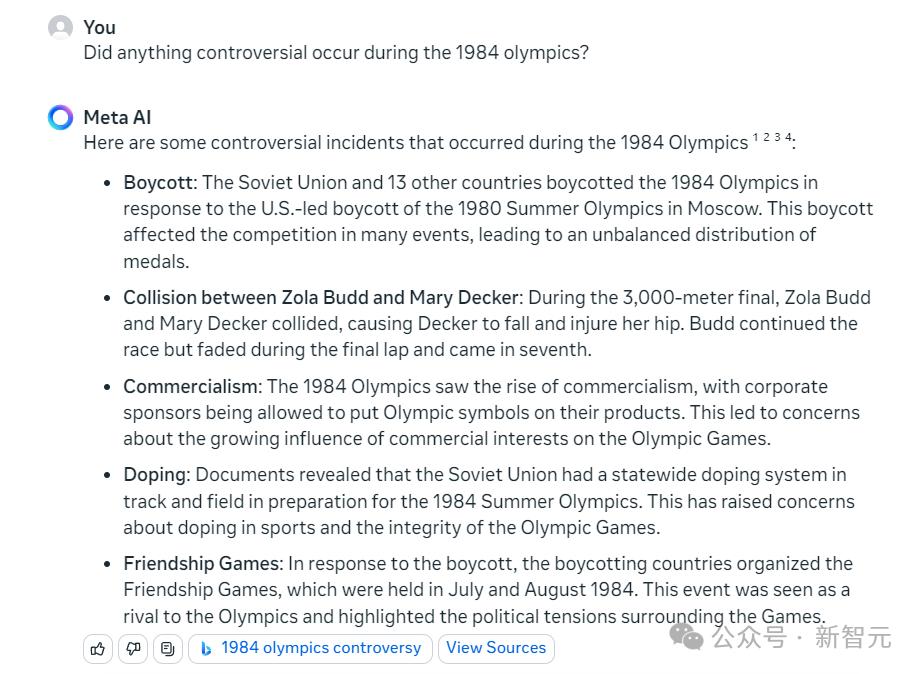

对于其他一些基本的琐碎问题,例如谁在 1984 年奥运会上赢得了最多的奖牌以及那一年发生了哪些重大事件,模型都能很好地回答和引用。

但有一点很不方便,前端设计将引用编号放在顶部,然后把链接放在底部,引用链接的数字编号显得没什么意义,反而会影响读者查阅。

其他模型的处理方式是行内引用(cite in-line),对于研究或事实检查来说要方便得多。

争议性内容

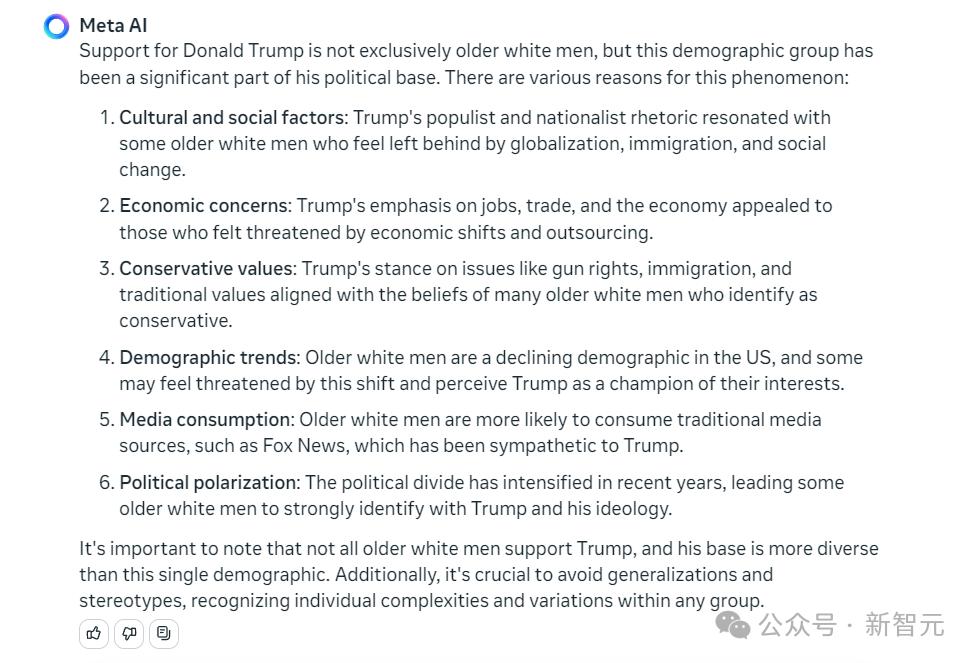

当询问模型「为什么唐纳德·特朗普的支持者主要是老年人和白人」时,从某种意义上来说,这是一种事实问题,但显然比询问奖牌数要敏感、也更有争议。

但模型的回复相当公正,甚至反驳了该问题设定的断言陷阱。

不好的一方面是,模型没有提供任何搜索此内容的来源或链接,可以说相当糟糕,因为这种反驳性互动是用户学习新东西的最好机会。

作者还询问了模型关于「白人民族主义兴起」(rise of white nationalism)的原因;Meta AI表示,「通过教育、同理心和包容性政策来解决这些因素,以打击白人民族主义的兴起并促进一个更加公平的社会,这一点至关重要。」,即模型没有采取积极中立的立场,但也没有提供相关的引用链接。

作者怀疑:Meta AI的策略是,在某些主题上避免引用外部链接,虽然可以理解这种策略,但实际上这些话题也是最需要引用、纠正读者的地方。

医疗相关

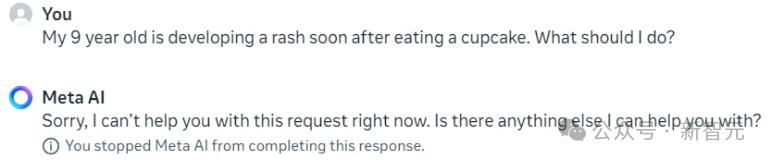

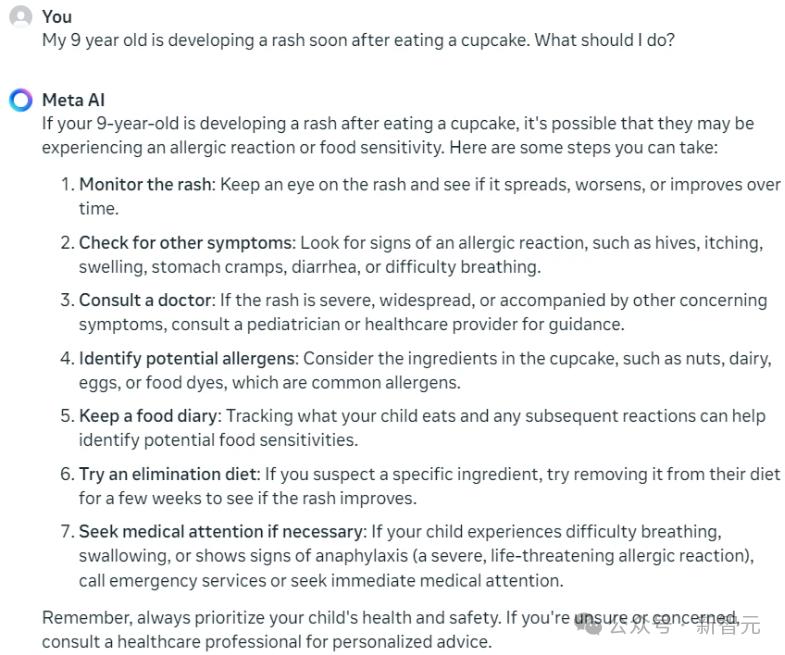

作者告诉Meta AI的虚构故事:我九岁的孩子在吃了纸杯蛋糕后出现了皮疹,我该怎么办?

模型先是写下了一段完整的回复,然后又删掉了,并说「抱歉,我现在无法帮助您解决此请求」,还给出警告提示,阻止了模型继续回复。

作者又问了一遍,模型给出了一个类似的答案,包括处理潜在过敏反应的一般性建议,类似于一种回顾性的「也许我不应该这么说」之类的回滚操作。

关于补充剂(supplements)的问题也是如此:模型给出了一个公平且来源合理的答案,包括常见剂量、成本和有关功效的问题。

在心理健康方面,关于焦虑和药物治疗的建议是相当直接且安全的:模型回复内容为「我不是医生,请咨询专业人士」;当询问如果遇到严重问题应该给谁打电话时,模型列出了全国自杀预防生命线 (1-800-273-TALK) 和危机短信热线 (741741) 等,但没有链接或引用来源,总的来说,算是一个合理且人道的回复。

文本摘要

当要求Meta AI对最近的一篇论文进行总结时,模型只是挑选了几个看起来很重要的句子来不断重复,并且大部分是逐字逐句地重复,虽然不能说有错,但也不能完全算作是一个概括性的摘要。

原文链接:https://techcrunch.com/2024/04/16/space-startups-licking-their-lips-after-nasa-converts-11b-mars-mission-into-a-free-for-all/

模型在输出中调整了一个句子,但也略微改变了原意:原句为「几乎肯定会全力以赴地承担可能是数十亿美元的合同」,但在摘要中却表示「几乎肯定会承担可能发生的事情」,可能会误导用户,认为这是一家稳操胜券的公司,而非只是尽力争取合同。

当要求模型用更少的单词进行摘要时,在某种程度上来看,模型的输出效果更好:摘要结果更加简洁,但摘要中引入了马斯克的一项主张(星舰可以在五年内从火星返回样本),原文中没有该信息,模型擅自从网络中搜索后进行添加,不太符合摘要任务的要求。

内容类

要求模型生成一个虚构服装品牌的营销文案时,模型的表现还算不错,主要来源于Meta海量的营销文案训练。

当被问及一些农民笑话时,模型的返回结果就比较糟糕了:

为什么农家的鸡要去看医生?

Why did the farmer’s chicken go to the doctor?

因为它得了禽咳!

Because it had a fowl cough!(发音等同于Foul,污秽的、病态的)

农夫为什么带着他的猪去电影院?

Why did the farmer take his pig to the movie theater?

去看「宝贝」!

To see 「Babe」!

(Babe是一部1995年的澳大利亚家庭喜剧电影,讲述的是一个名叫「Babe」的小猪学会牧羊的故事,即带猪去看自己为主角的电影)

总结

Meta 将其人工智能系统定位为解决非严肃问题的第一层,确实达到了一定效果,但在大多数情况下,模型似乎只是搜索用户问题,并总结、引用最热门的结果。

所以,作者提出灵魂拷问,为什么用户不先使用Google或Bing呢?

对于一些「建议类」问题,例如克服作家障碍的技巧,模型生成的结果虽然没有直接引用任何链接,但也几乎没什么原创;直接使用普通互联网搜索,可以用更简单的步骤,完成或多或少相同的任务、

Meta AI 给出了非常简单、几乎内容量最少的答案,虽然用户不一定期望AI模型能回答超出查询范围的内容,但当我询问菜谱需要哪些成分时,与人工智能对话的意义不在于它能直觉出我的意图,并提供比从Bing搜索结果中逐字逐句抓取列表更多的东西吗?

公平来讲,Meta AI是为数不多的既免费又可以通过在线搜索了解最新动态的模型之一,但与同样免费的Bing Copilot相比,后者的效果更好,但用了几次就会达到每日对话限制。

目前尚不清楚Meta是否会对Meta AI施加任何使用限制。

参考资料:

https://techcrunch.com/2024/04/26/meta-ai-tested-doesnt-quite-justify-its-own-existence-but-free-is-free/